La red Internet es fruto, en gran parte, de la combinación de ciencia y programas de investigación con fondos militares de EE UU. Aunque tuvo financiación militar nunca tuvo aplicación u objetivos militares.

Desde sus inicios, en ARPAnet (

Advanced Research Projects Agency NETwork), a los científicos se les permitió publicar sus resultados que fueron puestos a disposición del público de forma gratuita y sin patentes.

A mediados de los años 70, el Departamento de Defensa de EE UU intentó privatizar ARPAnet, ofreciéndoselo a

AT&T de manera gratuita. AT&T lo rechazó: "

Nunca podrá ser rentable, no vemos ningún interés en comercializarlo".

Los operadores de las telecomunicaciones han puesto, siempre que han podido, trabas al desarrollo abierto de Internet en cada país.

Internet se desarrolla gracias a una red internacional de científicos que trabajan cooperativamente. NO es una creación únicamente norteamericana, pese a lo mucho que se repite este

mantra en la actualidad. La World Wide Web, el sistema de navegación que hoy utiliza todo el mundo, lo inventó/desarrolló Tim Berners-Lee (británico) desde su laboratorio en el

CERN (Suiza).

Desde el principio la tecnología de Internet y sus protocolos fluyen de manera abierta y gratuita, eso ha sido la clave del crecimiento de esta tecnología, acelerando la evolución e innovación de la red.

Desde sus inicios hubo una relación directa entre los desarrolladores de la nueva tecnología y sus usuarios.

Al principo, la red fue creada para obtener mayor capacidad de proceso entre ordenadores, casi sin quererlo, para coordinar mejor los grupos de trabajo, se enviaron mensajes a través de la incipiente red: acababan de inventar el correo electrónico, la aplicación con más uso desde los inicios de Internet.

Fuente de información:

PRE-HISTORIA DE INTERNET

En el contexto de

Guerra Fría en el que se encontraban las dos mayores superpotencias (

URSS y EE UU), el lanzamiento del

Sputnik (primer satélite artificial, soviético) en octubre de 1957, desencadenó como reacción en 1958 el establecimiento de la

Defense Advanced Research Projects Agency (DARPA) en el Departamento de Defensa estadounidense para restablecer el liderazgo de EE UU en ciencia y tecnología.

La primera descripción escrita y publicada que podemos encontrar que hace referencia a relaciones interpersonales a través de una red es una serie de notas escritas por

Joseph C. R. Licklider y

Wesley Clark, del

MIT, que se publicaron en agosto de 1962, “

On-Line Man Computer Communication”. Imaginaron un conjunto de ordenadores interconectados a través de los cuales se podría tener acceso a datos y programas de cualquier sitio, presentando un concepto muy parecido a la Internet de hoy en día. Licklider acabará siendo el primer jefe del programa Computer Science, dedicado a hacer progresar la informática, en la agencia DARPA.

El 31 de mayo de 1961,

Leonard Kleinrock, también del MIT, había publicado los resultados de su tesis doctoral: “

Information Flow in Large Communication Nets”, creando conceptos básicos y el marco teórico sobre los

flujos de información en redes de comunicación muy grandes (

Teoría de colas). Fue publicado en forma de libro en 1964. Esta teoría general tiene en la actualidad aplicaciones en muchos campos. Se utiliza como base del comportamiento estocástico de los sistemas

store & forward (almacenamiento y reenvío). Muchos años después Internet sería un sistema basado en el almacenamiento y reenvío. Su original trabajo sobre

teoría de colas estudiaba los tiempos de espera de personas o cosas en una cola, así como las longitudes de la cola y las probabilidades asociadas a que exista un atasco o bloqueo, diseñando sistemas para reducir el tiempo de espera.

En 1964

Paul Baran (de la

RAND Corporation de Santa Mónica, California) publicó un extenso y detallado estudio: “

On distributed communications networks”. Trataba del diseño de una red de voz sin punto de fallo único, que siguiera funcionando ante la caída de unos cuantos

nodos. A pesar de que finalmente no tuvo nunca implementación práctica, se considera una de las bases de la

conmutación de paquetes.

Paul Baran:

" A finales de la década de los cincuenta la Guerra Fría se encontraba en un momento delicado y el principal problema al que se enfrentaba el mundo entero era que ambos bandos planeaban construir sistemas de misiles altamente vulnerables. Los estudios realizados por RAND mostraban que los sistemas de mando y control estratégico estadounidenses serían destruidos por los misiles soviéticos. Pensé que este era un problema grave y que podría contribuir en la búsqueda de una solución. Entonces, ideé un diseño de sistema basado en una red altamente distribuida de nodos, una red capaz de sobrevivir...(...) mi concepto básico fue el paralelismo o redundancia de las comunicaciones, tienen que fallar muchas partes para que no exista ninguna ruta entre dos nodos cualesquiera. Esto requería el uso de señales digitales y de "paquetes", que yo llamaba entonces "message block"..."

Curiosamente, el estudio de Paul Baran permaneció totalmente desconocido para

DARPA.

Y en 1965, el británico Donald Davies, desconociendo totalmente a Paul Baran, llegó a crear el mismo concepto, escogiendo la misma velocidad de datos (1,5 mbps) y la misma longitud del paquete (1024 bits), llamó a su sistema: conmutación de paquetes (packet switching), denominación que finalmente triunfó. Davies explicó que utilizó "paquetes", para diferenciarlos de conmutación de mensajes que era utilizado desde la época del telégrafo.

Davies vio que un problema importante con los nuevos sistemas informáticos de tiempo compartido era el elevadísimo coste de mantener una conexión telefónica abierta para cada usuario. Se dio cuenta de que mandar un archivo entero entre dos ordenadores, mediante un flujo ininterrumpido de datos era una manera muy ineficiente de proceder. Básicamente porque el tráfico digital entre ordenadores tiene largos períodos de silencio y se produce a ráfagas. Por ello concibió que el flujo de bits se rompía en mensajes cortos, paquetes.

Sus ideas de conmutación de paquetes la presentó de forma tardía en una conferencia en Edimburgo, el 5 de agosto de 1968. Pese a que un miembro de su equipo, Roger Scantlebury, ya había compartido sus ideas en un simposio en 1967, en Tennessee.

Los sistemas basados en la conmutación de paquetes cogen los datos que hay que transmitir y los trocean en pequeños paquetes a los que se les asigna la dirección de origen (remitente) y la de destino. Cada paquete se transmite de manera individual. En función del tráfico de los distintos enlaces por los que pasan, los paquetes pueden seguir diferentes rutas hacia un mismo destino, donde una vez que lleguen, deberán ser reordenados y ensamblados reconstruyendo el mensaje.

En la actualidad existe controversia, fomentada por Kleinrock, sobre la paternidad de la conmutación de paquetes. En 1996 Leonard Kleinrock, empieza a decir públicamente que él ha creado los principios básicos de la conmutación de paquetes, e incluso se adjudica la invención de la tecnología de Internet. Desde finales de los noventa, coincidiendo con la popularización y gran auge de Internet, Kleinrock, inició su particular campaña de autopromoción, ante la perplejidad de sus colegas y resto de pioneros, y el lógico enfado de las dos personas, Paul Baran y Donald Davies, que durante 40 años fueron consideradas los padres de la conmutación de paquetes.Y su autoproclamación tuvo y tiene amplia difusión en Internet.

En febrero de 1965, el director de la oficina

IPTO (Information Processing Techniques Office) de DARPA,

Ivan Sutherland, ofreció a

Larry Roberts del MIT un contrato para desarrollar una red informática y, en julio, se lo ofreció también a

Thomas Marill, para que ambos programaran y probaran dicha red.

Larry Roberts

En octubre de 1965 se produjo

la primera prueba,

el ordenador TX-2 del Lincoln Laboratory del MIT (Larry Roberts, Boston) fue conectado al ordenador Q-32 de System Development Corporation (Thomas Marril, Santa Mónica).

Y en octubre de 1966 documentaron estos experimentos y los presentaron en la conferencia AFIPS (

American Federation of Information Processing Societies).

Este experimento demostró que era posible establecer enlaces de larga distancia entre dos ordenadores, pero que hacerlo utilizando la tecnología de conmutación de circuitos (red telefónica clásica, 1200 bits por segundo) era problemático, por lo que esta última no resultaba adecuada para estos fines.

En diciembre de 1966, Bob Taylor convenció finalmente a Larry Roberts, para que dejara el MIT y fue contratado como investigador jefe en DARPA. Es allí en donde inmediatamente comienza el diseño del sistema de una red de área extendida (

WAN) que posteriormente sería conocida como ARPAnet.

Ya en abril de 1967, Roberts organizó una sesión de diseño de ARPAnet en Ann Arbor (Michigan) a la que asistieron los investigadores principales de cada uno de los contratistas de la oficina

IPTO.

En octubre del mismo año, 1967, la

Association of Computing Machinery organizó un simposio sobre Principios de Sistemas Operativos (

Operating System Principles) en Gatlinburg, Tennessee.

El último día se presentaron ponencias sobre temas de comunicaciones y fue en una de ellas donde se hizo público el artículo con el primer diseño de

ARPAnet expuesto por Larry Roberts.

En otra ponencia, el británico Roger Scantlebury presentó los avances del equipo del National Physical Laboratory (NPL) liderado por Donald Davies, que había usado por primera vez el término “paquete”.

Fue en este simposio donde los equipos de NPL (UK) y ARPA (EE. UU.) se conocieron personalmente y, a su vez, sería el NPL quien pondría en conocimiento de ARPA la existencia de los pioneros trabajos del norteamericano Paul Baran (de la RAND Corporation).

Roger Scantlebury:

"Recuerdo bien mi presentación en octubre de1967, un artículo sobre conmutación de paquetes. Allí conocí a Larry Roberts, quien en esa época estaba preparando los planes para construir ARPAnet. Así que toda la labor que realizamos en los años siguientes, junto con los colegas de ARPA, es considerada como los orígenes del networking. Ayudamos a iniciar todo el sistema.

En el programa del simposio se incluyó una sesión sobre telecomunicaciones, porque en ese momento el acceso remoto a ordenadores y la idea de conectar estas máquinas entre sí empezaba a estar de moda.

Presentamos nuestra idea novedosa de conmutación de paquetes, que los participantes no habían oído nunca antes.

Otra de las contribuciones fue el artículo de Larry Roberts sobre la futura red ARPAnet, que principalmente era una red de ordenadores que se iba a instalar en las universidades y en laboratorios de investigación del Gobierno (EE. UU.). La idea era conectar entre sí los recursos informáticos y poder dar acceso a los recursos compartidos.

Mi aportación a Roberts fue ofrecerle que utilizara esta técnica de la conmutación de paquetes que estábamos presentando. Creo recordar que al principio Roberts no fue totalmente receptivo con la idea, pero en 1969, cuando los de BBN instalaron el primer nodo para ARPA, por supuesto la idea fue ampliamente aceptada.

Así que estoy seguro de que nuestro artículo (firmado por Donal Davies, Peter Wilkinson, Keith Barlett, y yo mismo) fue el inicio del concepto de transmisión de alta velocidad y de la conmutación de paquetes.

Ahora bien, ya existía el artículo de Paul Baran que conocimos en los momentos previos a la elaboración de nuestro artículo para el simposio. Y resultó que Baran había tenido una idea muy semejante a la nuestra, pero su diseño estaba destinado a una red de voz muy segura, una red táctica militar que sobreviviera a un ataque nuclear, y utilizó la misma idea de la conmutación de paquetes, pero no la llamó así. Recuerdo muy bien que a Larry Roberts y los demás les mostré este artículo de Baran, aunque no trataba de lo mismo, ya que no estaba destinado a una red de ordenadores, sino que planteaba una red de voz y una red militar segura."

Durante 1967, el equipo de Donald Davies (del NPL, Middlesex, Inglaterra) desarrolló la NPL-Data-Network. Esta red experimental, denominada NPLnet, de conmutación de paquetes utilizaba líneas de altísima velocidad: 768 kbps. Una red que era utilizada para atender neccesidades internas del laboratorio y demostrar la viabilidad de la conmutación de paquetes. La NPLnet entraría realmente en servicio en 1970.

Ya en 1968, Larry Roberts escribió y presentó a ARPA el plan llamado

Resource Sharing Computer Networks (Redes de Ordenadores de Recursos Compartidos). Se trataba de poder construir una versión funcional de la red. El proyecto se justificaba, por sí solo, argumentando que los diferentes departamentos de investigación podrían conectarse a otros equipos y usar sus programas de forma remota, ahorrando así los costes de compra o la creación de programas propios. Roberts dio el informe a Bob Taylor el día 3 de junio de 1968, y éste lo aprobó el 21 del mismo mes, fecha en la que se iniciaron los trabajos.

Jon Postel, Steve Crocker, Vint Cerf

El 29 de julio de 1968, ARPA realizó una solicitud pública de propuestas para construir los

IMP (pequeños ordenadores que harán las funciones de router y constituirán los nodos de la red ARPAnet), que se envió finalmente en agosto.

En el mismo verano de 1968,

IPTO convocó una reunión de estudiantes graduados en Computer Science de las universidades, que compondrían los primeros cuatro nodos de la red, de manera que se les involucró desde el primer día, y desde ese verano empezaron a colaborar para resolver los problemas fundamentales de la comunicación host-to-host (extremo a extremo, entre dos ordenadores, pasando por los nodos intermedios o

IMP).

De esta manera, se creó el

Grupo de Trabajo de Red (Network Working Group, NWG) formado por estudiantes que empezaron a registrar metódicamente sus ideas y deliberaciones en un conjunto de notas que

Steve Crocker llamó

Request for Comments, RFC. Con el tiempo, los estudiantes, entre los que se encontraban

Jon Postel y

Vinton Cerf , diseñaron el primer protocolo de ARPAnet, el

NCP (Protocolo de Control de Red), y los primeros servicios, acceso vía terminal a un ordenador remoto (

TELnet) o programas de transferencia de ficheros (

FTP), entre muchos otros elementos.

Interface Message Processors (o IMP)

En enero de 1969, una pequeña consultora de Boston:

Bolt Beranek and Newman (BBN), con una propuesta liderada por

Frank Heart, se adjudicó el contrato para la construcción e instalación de lo que se llamó

Interface Message Processors (o IMP), que posteriormente evolucionaron a gateways o pasarelas y que finalmente, en la actualidad, todos conocemos como

routers.

Los nodos se fueron instalando a medida que BBN iba construyendo cada IMP (basado en un miniordenador

Honeywell DDP-516 de 12 kilobytes de memoria). Por otro lado, el casi-monopolio de telecomunicaciones

AT&T, proporcionó las líneas que multiplexadas permitían obtener unos enlaces a 50 kbps.

1969_ NODOS_Host/ordenadores conectados a la red ARPAnet inicial:

Nodo 1, Los Angeles: UCLA (conectado el día 2 de septiembre de 1969).

Función: Centro de Medición de la Red.

Ordenador: SDS-SIGMA 7 con SEX como sistema operativo.

Nodo 2, Standford: SRI: Instituto de Investigación Stanford (el 1 de octubre de 1969).

Función: creación del Network Information Center (NIC).

Sistema operativo y ordenador: SDS 940/Genie.

Proyecto de D. Engelbart (inventor del ratón) sobre aumento de la inteligencia humana.

Nodo 3, Santa Barbara: UCSB: University of California, Santa Barbara (1 de octubre de 1969).

Primer sistema (Culler-Fried Online System) para el cálculo matemático gráfico.

Y Roland Bryan, con el ordenador: IBM 360/75, OS / MVT.

Nodo 4, Salt Lake City: University of Utah (diciembre de 1969).

Su especialidad eran los gráficos.

El ordenador: un DEC PDP-10, con Tenex de sistema operativo.

El

7 de abril de 1969, se publicó el primer protocolo de ARPAnet, se llamó

Host Software y fue escrito por

Steve Crocker.

La creación de ARPAnet nunca tuvo un fin puramente militar, la realidad es que pretendía el intercambio de recursos, conectando entre sí los grandes ordenadores de la época. Se construyó para que la gente con acceso a la informática interactiva pudiera compartir información.

Los primeros paquetes se enviaron el día 29 de octubre de 1969 cuando Charley Kline (UCLA), al tratar de conectarse y entrar en el ordenador del SRI (donde estaba Bill Duval), consiguió enviar las letras L, O, G (de “login”); momento en el que el sistema se bloqueó.

A partir de aquí, cada mes, BBN fue construyendo, transportando e instalando un IMP a cada uno de los contratistas de investigación que tenía ARPA, mayoritariamente universidades.

En junio de 1970, ya había dos líneas de comunicación que atravesaban los Estados Unidos y que conectaban el MIT, BBN y Harvard con seis IMP instalados en la costa oeste californiana. El esquema original permitía un máximo de 64 conmutadores (IMP) y un máximo de 4 ordenadores (hosts) por cada IMP.

A finales de 1970 el grupo de Steve Crocker terminó la primera versión del protocolo NCP, este fue el lenguaje en el que hablaría ARPAnet hasta el 1 de enero de 1983, momento en el que se adoptó el TCP/IP Transport Control Protocol/ Internet Protocol (que será inventado por Vint Cerf y Robert Kahn en 1973).

En 1972 existían otras redes que se desarrollaron simultáneamente y de forma independiente a ARPAnet: SITA, Tymshare/Tymnet, INFOnet, Cyclades, ...

En marzo de 1972, Ray Tomlinson escribió la primera aplicación de envío y recepción de mensajes de correo electrónico, SNDMSG (Send Message), motivado por la necesidad de comunicación y coordinación entre los distintos desarrolladores del proyecto ARPAnet.

A partir del congreso, ICCC, se popularizó el uso del correo electrónico en los ambientes académicos estadounidenses.

Ray Tomlinson había trabajado en su laboratorio de Cambridge en un protocolo de transferencia de ficheros denominado CPYnet, que enviaba archivos entre ordenadores a traves de una conexión de red, pero sin permitir que los usuarios añadieran información a los archivos.

Tomlinson, ya en 1971, había escrito un programa de correo para el sistema operativo

Tenex (TEN-extended) utilizado por la mayoría de los ordenadores de la red ARPAnet, en ese momento disponían de

28 ordenadores y menos de mil usuarios, por lo que fue difícil estimar el impacto futuro de esta forma de comunicación.

La primera versión del programa consistía en dos partes: SNDMSG (permitía componer y enviar un mensaje al buzón de otro usuario) y READMAIL (para recibir y leer los mensajes de nuestro buzón).

El buzón era un fichero con un nombre determinado y tenía la particularidad de que los otros usuarios únicamente podían añadir texto al fichero, pero no leerlo ni borrarlo. Era un programa creado para un sistema de tiempo compartido, pensado para gestionar los mensajes entre los usuarios de un mismo ordenador. Sin poder transmitirlos entre máquinas.

Finalmente combinó los protocolos CPYnet y los programas SNDMSG-READMAIL, y en el otoño de 1971 Tomlinson envió el primer mensaje entre dos ordenadores, que estaban uno al lado del otro en

Bolt Beranek and Newman (BBN).

El primer correo que envió fuera del laboratorio lo dirigió a su grupo de investigación, anunciando la disponibilidad del correo en la red, explicaba cómo usarlo e incluía el símbolo

@ para separar el nombre del usuario del nombre del ordenador.

El símbolo "arroba" @, pasó del anonimato del teclado a ser la estrella de Internet en la actualidad.

Tomlinson miró con atención el teclado que usaba, un ‘modelo 33 teletype’. Necesitaba un carácter que no apareciese en ningún servidor o nombre individual. Además de las letras y números, el teclado tenía una docena de símbolos de puntuación.

En la segunda fila, en la parte derecha de su teclado, Tomlinson encontró la solución perfecta. El símbolo @ no aparecía en nombres, así que no habría ambigüedad: el nombre del usuario y el nombre del servidor estarían perfectamente separados.

El @ también tenía la ventaja de significar "at" en inglés, evolución de la partícula latina ad (para, hacia). Fue una brillante decisión.

Steven Lukasik, director general de ARPAnet, decidió usar esta herramienta con criterios de gestión empresarial y organización, por lo que encarga a Larry Roberts (arquitecto de la red ARPAnet) la mejora de la aplicación, se convirtió así en el primer desarrollador de una versión más versátil y amigable de correo electrónico.

En el año 2001 se enviaban diariamente 7000 millones de correos en todo el mundo.

En 2005, 36000 millones de correos diarios.

En 2011, 294000 millones diarios. El número de cuentas de correo se estima en 2900 millones de usuarios. La mayoría de las cuentas son gratuitas (Gmail, Yahoo-mail, Hotmail/Outlook,...)

.

RAYMOND S. TOMLINSON PREMIO PRÍNCIPE DE ASTURIAS DE INVESTIGACIÓN CIENTÍFICA Y TÉCNICA 2009

HISTORIA DE INTERNET

A principios de los años setenta había varias redes que funcionaban mediante la técnica de conmutación de paquetes,

ARPAnet (terrestre),

SATnet (vía satélite) y

PRnet (vía radio). Se trataba, pues, de encontrar el modo de interconectarlas, de manera que cualquier ordenador de una de ellas pudiera hablar con cualquier ordenador de la otra red, asegurando unos principios que serían clave para el futuro desarrollo de Internet.

Robert Kahn

.

Robert Kahn se había ocupado de la definición de estos principios básicos sobre comunicaciones mientras trabajaba en BBN: la no existencia de un control central, la independencia de las redes conectadas y la utilización de pequeños ordenadores específicos, gateways o routers, para asegurar el tráfico entre redes.

Vinton G. Cerf

.

Robert Kahn se puso en contacto con

Vint Cerf (Standford University) para trabajar con él en lo que entonces se denominaba el

INTER-NETworking Problem (del que derivaría el popular nombre

de

INTERNET).

Iniciaron sus trabajos en el nuevo protocolo en la primavera de 1973 y en septiembre de ese mismo año presentaron en el

INWG organizado en Sussex (UK) una primera versión escrita de los resultados.

Durante el curso académico 1973-1974, Vint Cerf, con su grupo de investigación de redes en Stanford y después de muchas simulaciones, logró la primera especificación del protocolo, Transport Control Protocol,

TCP/IP. Vint Cerf indica específicamente y agradece de forma explícita la importante influencia de los franceses

Louis Pouzin (diseñador de

CYCLADES, 1972) y de su colega,

Hubert Zimmerman, en el diseño del TCP.

El protocolo IP (Internet Protocol) regía el correcto direccionamiento de los paquetes a través de la red.

El protocolo TCP (Transport Control Protocol) velaría por que los paquetes llegaran al destinatario de manera segura y sin errores (mediante control de flujo y recuperación de paquetes perdidos)

En 1974, Kahn y Cerf publicaron su famoso artículo “

A protocol for packet network intercommunication”.

Las cuatro claves principales de este documento:

i) La comunicación entre dos procesos consistiría en un largo flujo de bytes identificados según su posición dentro de la cadena de información transmitida.

ii) El control de flujo se debería realizar mediante "acuses de recibo" (mensajes de aceptación) que indican que la información ha llegado a su destino corectamente. La aceptación sería acumulativa, dando por buenos los mensajes recibidos hasta ese momento.

iii) Origen y destino se ponían de acuerdo a los parámetros exactos de longitud de los mencionados flujos de bytes.

iv) Las direcciones IP quedaron (para siempre) definidas mediante cuatro números separados por puntos (194.140.141.2) que corresponden a 4 bytes (32 bits) por dirección IP. Se definió un espacio de direcciones de tan solo 32 bits (4 bytes), los

primeros 8 bits identificaban la red (194) y los 24 restantes el equipo de esa

red (140.141.2).

Vint Cerf reconoce que en ese momento pensaron que en el futuro no podrían existir demasiadas redes debido a su gran coste de implantación y mantenimiento, se pensaba en redes con cobertura interestatal estadounidense y en alguna extranjera, como la francesa CYCLADES o la británica NPLnet.

Vint Cerf reconoce, en la actualidad, que jamás hubiera podido imaginar que Internet tendría más de 128 redes conectadas. Hoy sabemos que se conectan centenares de millones de ordenadores, teléfonos móviles, satélites, agendas personales, electrodomésticos,...

Internet NO fue diseñada

para tener una aplicación específica, sino como una infraestructura

sobre la que poder desarrollar nuevas aplicaciones. De hecho, el WWW,

World Wide Web no aparece hasta 25 años después, el

intercambio de música entre dos programas clientes (Napster), el chat en tiempo real, transmisión de voz (Skype)...

Esto pudo ser así gracias a la naturaleza generalista con que fueron

diseñados los servicios proporcionados por los protocolos TCP e IP.

Posteriormente, ARPA contrató a tres grupos distintos para que desarrollaran distintas versiones operacionales del protocolo sobre distintas plataformas de hardware:

- BBN Technologies (Ray Tomlinson)

- Stanford University (Vinton G. Cerf)

- University College of London (

Peter Kirstein)

En 1975 se llevó a cabo una primera prueba del

TCP/IP con dos redes, entre Stanford y el University College de Londres (UCL).

El 22 de noviembre de 1977 se realizó un exitoso test de interconexión que enlazó ubicaciones de Estados Unidos (SRI, Don Nielson), Reino Unido (UCL, Peter Kirstein) y Noruega (Pål Spilling).

Esta prueba consiguió unir redes con tecnologías de acceso totalmente distintas:

ARPAnet (terrestre),

SATnet (satelital) y

PRnet (vía radio).

Es en este momento puntual de la historia cuando podemos fijar el nacimiento real de internet como red formada por dos o más redes distintas.

En 1981, la National Science Foundation, NSF, subsidió la creación y desarrollo de la

Computer Science Network CSnet (de

Larry Landweber) con la que miles de personas se conectaron por primera vez a una red.

CSnet se conectó a ARPAnet a través de TCP/IP, permitiendo conectar a muchos departamentos universitarios que no disponían de grandes recursos técnicos.

Los protocolos TCP/IP fueron considerados una solución transitoria a la espera de que se desarrollaran de forma oficial

los protocolos OSI,

Open Systems Interconnection,

situación que jamás ocurrió.

Con la aparición del PC (

Personal Computer),

introducido por IBM el 12 de agosto de 1981, con un coste de 1500 dólares, se vio que las versiones del TCP/IP, pensadas para los grandes ordenadores de la época, eran demasiado complejas para ser ejecutadas en un ordenador personal.

A medida que Internet evolucionaba y mejoraba técnicamente, se hacía cada vez más complicado distribuir las nuevas versiones de software de los servidores.

DARPA financió a la Universidad de Berkeley para que incluyeran en su conocido sistema operativo

UNIX los protocolos TCP/IP.

Bill Joy (posterior cofundador de Sun Microsystems) reescribió el código TCP/IP, adaptándolo e incorporándolo de serie a las nuevas versiones UNIX BSD, a partir de 1983. Así, en poco tiempo el TCP/IP estuvo disponible de manera gratuita en todas las universidades. Esta fue la clave del desarrollo, difusión y aceptación del TCP/IP en entornos académicos.

La implantación del sistema operativo UNIX en la gran mayoría de universidades expandió a su vez la red

USEnet, basada en los protocolos de comunicación

UUCP (UNIX to UNIX Copy) que venían integrados de forma gratuita.

Dave Clark dirigió un equipo en el MIT que demostró que una estación de trabajo (en el futuro un PC) también podía utilizar una versión reducida y adaptada de los protocolos TCP/IP. El resultado fue la creación de la compañía

FTP Software en 1986, por John Romkey.

Hasta 1995 para tener acceso a Internet se debía instalar manualmente dicho protocolo. Más tarde el paquete de protocolos de comunicaciones de Internet fue incorporado directamente por los sistemas operativos de los ordenadores personales (PC).

En 1981 se creó

BITnet, que enlazaba muchos de los grandes

mainframes IBM académicos.

Su rama europea, 1982, fue la red EARN (European Academic and Research Network) que tenía su nodo central español en la Universidad de Barcelona.

En 1982 se crea la red EUnet como una réplica europea de la americana USEnet (que funcionaba desde 1979). La red europea tenía enlaces UUCP (UNIX to UNIX Copy) establecidos entre cuatro países: UK, Holanda, Dinamarca y Suecia, y que en 1988 convertirá sus enlaces a tecnología IP de Internet.

Esta creciente diseminación de redes y de tecnologías llevó a un alto grado de incompatibilidad entre ellas. Utilizadas por distintos colectivos dan lugar a islas de comunicación que se desarrollan por separado durante mucho tiempo. En los años posteriores se intentó paliar este efecto con programas de ayuda al desarrollo de las redes universitarias.

En marzo de 1982, el Departamento de Defensa de la administración americana decidió que todos sus nodos utilizaran TCP/IP, declarando este como el único estándar para todas las redes de ordenadores militares y requiriendo su uso a partir del día 1 de enero de 1983.

A finales de 1983, los casi 140 nodos (con más de 300 ordenadores conectados a ARPAnet) fueron divididos en dos redes distintas conectadas por una pasarela o gateway. Estas pasarelas fueron inicialmente diseñadas y programadas por Ginny Strazisar, de BBN.

Los nodos que se dedicaban a fines científicos y universitarios mantuvieron el nombre de ARPAnet y la otra red más pequeña que se dedicó a servir a las necesidades de defensa fue llamada MILnet.

A medida que Internet iba creciendo, se iban generando nuevas

necesidades y creando nuevos conceptos que hicieron variar profundamente

la tecnología.

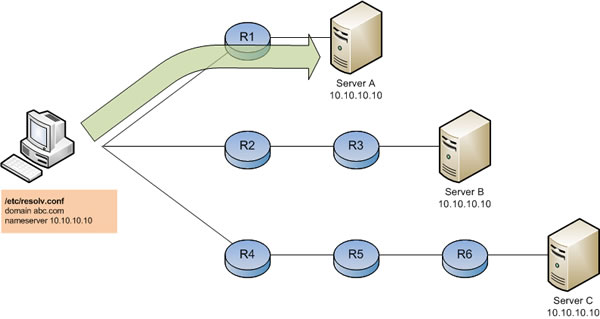

Para simplificar el uso, se asignaron

nombres a las máquinas. Inicialmente se resolvió mediante una simple

tabla que cada ordenador guardaba localmente en un fichero, en el que se

reflejaban todas las máquinas con sus nombres y direcciones IP

asociadas. Puesto que las actualizaciones eran constantes, este sistema

pronto se hizo ingestionable. Durante meses esto bloqueó el desarrollo

de Internet, hasta que se implantó el nuevo sistema con una base de

datos distribuida a nivel global: el DNS (Sistema de Nombres de Dominio).

Este permite la resolución de nombres de máquinas en direcciones de

Internet, manteniendo centenares de miles de máquinas actualizadas, de

forma jerarquizada.

El DNS fue inventado y desarrollado,

para afrontar el crecimiento de la red a principios de la década de los

80, por Paul Mockapetris en colaboración con Jon Postel (USC) y Paul

Vixie. Las universidades empezaban a realizar conexiones a las múltiples

redes, como BITnet. Era de vital importancia establecer un orden

metódico en cuanto a los nombres de los equipos que se iban

incorporando. Se crearon los nombres de dominio genéricos de primer

nivel (gTLD):

".com" ".org" y ".net". Pronto se añadieron ".mil"(ejército EE UU)

".edu" (universidades americanas) ".gov" (agencias de administración de

EE UU).

Una anécdota que ilustra lo

impredecible que fue Internet: cuando se estaban decidiendo los nombres

de los dominios de nivel superior se pensó en no incluir ".com"

(comercial) pues se pensaba que Internet solo tendría uso en educación y

en el ejército.

Los

gTLD fueron administrados por el

Standford Research Institute- Network Information Center (SRI-NIC) en Menlo Park, que luego sería denominado InterNIC.

Además también se definieron los dominios nacionales por país,

ccTLD, gestionados por instituciones académicas.

Cuando Internet era una red de redes pequeña, un grupo de pioneros que operaba bajo el nombre de

IANA, eran los únicos que gestionaban las asignación de direcciones IP.

A mediados de los

ochenta la mayoría de los estados europeos no disponían de redes

internas. Y mientras los gobiernos y los grandes fabricantes discutían y

negociaban cuál sería la estrategia, y sobre todo, qué tecnología se

iba a implantar, los científicos del entorno de la investigación pública

se decantaron por la tecnología de Internet (TCP/IP), por su gratuidad y

por la facilidad de instalación y uso.

Desde los gobiernos y los monopolios de la telecomunicación se exigía que se utilizara el modelo de referencia OSI, estandarizado por ISO,

que de complejo que era jamás se llegó a desarrollar. Tuvieron que pasar

más de 10 años para que el sector privado aceptara los protocolos TCP/IP.

En Europa se produjo el cisma entre dos corrientes, la de los operadores de telecomunicaciones, CCITT, que desarrollaron sus estándares basándose en principios de la red telefónica, y la de los cientificos informáticos.

Los

operadores de telecomunicaciones, intentaban seguir con el modelo

telefónico, impusieron un modelo donde se debía establecer una llamada o

conexión entre dos ordenadores de manera previa a que pudieran

enviarse información. La factura se basaría en la duración de la

conexión, esto supuso una gran fuente de ingresos durante casi 10 años.

Por otro lado estaban los ingenieros informáticos, IETF, que

diseñaron los protocolos de red IP, un grupo abierto en el que todo el

mundo podía colaborar y proponer ideas. Proponían un modelo que no

requería la conexión permanente entre los dos ordenadores.

Mientras tanto, en Estados Unidos la red iba creciendo vertiginosamente desde que en 1983 se imponen los protocolos TCP/IP.

Los

primeros esfuerzos para poder disponer de una red internacional se

iniciaron en Oslo, en la reunión de julio de 1983, liderada por Larry Landweber. Estas reuniones se convirtieron a partir de 1991 en las

conferencias oficiales de la Internet Society, INET.

El 13 de junio de 1983 se pone en marcha en Amsterdam, la organización RARE, gracias al patrocinio del gobierno holandés, el primer líder de RARE será Peter Linington.

En

1986 RARE propuso a la Comisión Europea que se financiara el ambicioso proyecto COSINE., establecer una red europea para la investigación basada en

infraestructura OSI.

Este proyecto llevaba implícita la aceptación de que habría dos mundos,

con diferentes lenguajes de red, incompatibles entre sí y que obligaban

a utilizar gateways para establecer las comunicaciones.

La experiencia acumulada por la National Science Foundation (NSF) en el uso del TCP/IP en

CSnet fue fundamental para las grandes decisiones que el irlandés

Dennis Jennings tomó y que definieron para siempre

la red a la que podemos tomar como embrión de Internet: la red NSFnet, en 1986.

En el año 1988 comenzó la expansión internacional de la red NSFnet: Dinamarca, Francia, Islandia, Noruega, Suecia y Canadá. Se puso en marcha el CCIRN (Coordinating Commitee for Intercontinental Research Networks), en octubre, en la reunión en Virginia, los americanos Bill Bostwick, Barry Leiner, Dave Clark y Vint Cerf pidieron a los representantes europeos que establecieran un organismo para asignar las direcciones de Internet en Europa.

En diciembre de 1988, reunidos en el CERN, liderados por Daniel Karrenberg, proponen que RIPE se encargue de asignar las direcciones.

En 1988 el CERN bajo el impulso de Ben Segal, Francois Fluckiger y Brian Carpenter se alejan de la estrategia OSI. De hecho, el establecimiento de RIPE, a mediados de 1989, marca el comienzo de la Era Internet en Europa.

La

red COSINE se inicia en 1989, el año que se derribó el muro de Berlín.

Nunca se finalizó porque quedó eclipsada por la ola de instalaciones de

la tecnología Internet en todos los campus universitarios de Europa. Una

tecnología simple, fácil de instalar, integrada en las máquinas UNIX y

gratuita. Los usuarios podían enviar correos y ficheros entre ellos sin

tener en cuenta los tipos, marcas o modelos de ordenadores de sus

destinatarios.

Hasta finales de los 1980, Internet era una red únicamente utilizable por especialistas con altos conocimientos de informática. Por otro lado la tecnología hipertexto inventada muchos años antes, estaba confinada en aplicaciones multimedia ubicadas en CD-ROM o en alguna base de datos local.

En 1990 IBM, con Herb Budd al

frente, crea una red académica de supercomputación de altísimas

prestaciones, EASInet (European Academic Supercomputer Initiative

Network), basada en la tecnología de Internet, subsidiando los equipos

de conmutación y las conexiones internacionales durante 3 años.

EASInet

conectó los grandes centros de investigación y de supercomputación

europeos entre sí en forma de estrella, conectando el nodo central

europeo directamente a la NSFnet americana. Esto supuso que el CERN

(Conseil Européen pour la Recherche Nucléaire) que actuaba como hub o concentrador a nivel europeo, se conectara con la Cornell University en

febrero de 1990, con el primer enlace de más de 1 Mbps, lo que provocó

un auténtico terremoto entre la comunidad académica, fue así como se

forzó a que las distintas redes nacionales aún reacias, se conectaran,

finalmente, mediante la tecnología de Internet.

Los

países escandinavos fueron los primeros en convertir sus redes a

tecnología Internet TCP formando una federación gracias a la

organización NORDUnet, conectándose directamente a la NSFnet americana.

La red holandesa SURFnet fue una de las primeras en cambiar a protocolos de Internet. En UK la red JAnet también empieza su conversión.

Finalmente, el

1 de febrero de 1990 RARE toma la histórica decisión de aceptar la

tecnología de Internet, TCP/IP, y abandonar su política sobre el

protocolo OSI.

La

guerra de protocolos (IP versus OSI) se dio oficialmente por acabada en

junio de 1990, durante la conferencia en Killarney (Irlanda), al unirse

la red EARN con RARE. Resultado de esta unión fue la actual red TERENA.

La red entra en España en agosto de 1991, tras la conexión del Centre de Supercomputació de Catalunya (CESCA) con el Centre National Universitaire Sud de Calcul (CNSUSC) de Montpellier, bajo el patrocinio de la Fundació Catalana per a la Recerca (FCR).

A principios de los años 90 el 85% del ancho de banda internacional

instalado para Internet en Europa terminaba en el Centro de Cálculo ubicado en el edificio 513 del CERN.

La gran aportación de Tim Berners-Lee fue la de unir dos tecnologías, http + Internet, con décadas de antigüedad, de forma sencilla, dando a su unión una potencia que ha revolucionado la manera de guardar y recuperar la información.

La aparición del Hypertext Transfer Protocol, http, y su rápida estandarización son los factores clave que han hecho difundir Internet masivamente a partir de 1994. La importancia radica en el acercamiento que han producido sus desarrollos entre la red y el usuario sin conocimientos previos.

Hypertext Transfer Protocol.- Cuando escribes una dirección web en tu navegador y se abre la página que deseas, es porque tu navegador se ha comunicado con el servidor web por HTTP. Dicho de otra manera, el protocolo HTTP es el código o lenguaje en el que el navegador le comunica al servidor qué página quiere visualizar.

Tim Berners-Lee:

"Ya en 1980, durante una corta estancia en el CERN, escribí mi primer programa tipo web, llamado ENQUIRE, para que me ayudara a recordar las conexiones entre personas. Lo que buscaba era un software que permitiera almacenar y luego recuperar documentos. Todos los sistemas presentados en el CERN habían ido fracasando.

En 1989 retomé la idea del ENQUIRE. En aquella época, Internet era invisible en Europa. La tardanza del CERN en adoptar Internet fue sorprendente, teniendo en cuenta que había sido siempre pionero en las redes y en las telecomunicaciones. Se había desarrollado la CERN-Net con sus propios sistemas de e-mail. Fue Ben Segal (que había trabajado en EE UU y visto el potencial de Internet), quien se convirtió en el propagador solitario en el CERN de este tipo de tecnología.

Empecé pues a escribir el proyecto web en marzo de 1989. Lo entregué a Mike Sendall, a David Williams y a unos cuantos más. No hubo respuesta. Las Tecnologías de la Información, no tenían un foro receptivo. Probablemente, porque aquello era un laboratorio de Física.

Inicié un estudio profundo sobre el hipertexto y me convencí de que estaba en el camino correcto. A principios de 1990, seguía sin tener reacciones a mi propuesta, por lo que le di otra forma y le puse una nueva fecha, mayo de 1990, se la di a David Williams y de nuevo fue archivada.

Una de las personas que creyó en el proyecto desde el principio fue el científico belga: Robert Cailliau. Reescribió mi propuesta en términos que a él le pareció que tendrían más efecto y buscó ayudantes/estudiantes, dinero, aparatos y espacio de oficinas. Explicar la visión del proyecto web a personas y organizaciones resultó tarea excesivamente difícil sin tener un navegador web, por lo que a mediados de noviembre de 1990 tuve ya un programa cliente (navegador y editor) que llamé WorldWideWeb. Y en diciembre ya funcionaba con el Lenguaje Markup de Hipertexto (HTML) que había escrito y que describe cómo formatear páginas que contengan vínculos de hipertexto. También describí el primer servidor web. Ambos funcionaban en mi ordenador NeXT. Robert compró su propio ordenador NeXT y empezamos a compartir información (en local). Y fue el día de Navidad de 1990, con el navegador WWW instalado en mi ordenador y en el de Robert, cuando nos comunicamos a través de Internet con el servidor info.cern.ch por primera vez. En verano de 1991 empezó su distribución a través de Internet y en enero de 1993 el número de servidores conocidos, había llegado a casi 50."

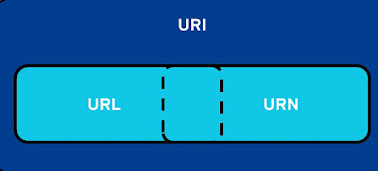

URI/URL.- La idea de un identificador uniforme de recursos, URI, fue concebida por Tim Berners-Lee, el padre de la red World Wide Web. Cuando el científico utilizó el término por primera vez en la RFC 1630, aún hablaba de un universal resource identifier, o identificador universal de recursos. Desde entonces, sobre todo debido a su uso en algunas publicaciones del World Wide Web Consortium (W3C), las siglas URI empezaron a referirse a uniform resource identifier, y así es como las entendemos hoy en día. Su estructura, no obstante, no ha cambiado en absoluto desde su creación.

El URI o identificador uniforme de recursos sirve para acceder a un recurso físico o abstracto por Internet.

Las siglas URI, URL se refieren a conceptos muy similares en términos técnicos. El URL o uniform resource locator se utiliza para indicar dónde se encuentra un recurso. Por lo tanto, también sirve para acceder a algunas páginas web por Internet. El URL es una subcategoría del URI.

Lenguaje de programación Viola

Por otro lado y casi simultáneamente, Pei Wei, un estudiante de la Universidad de Berkeley, crea un lenguaje de programación interpretado llamado Viola (para Unix). Tenía una gran funcionalidad para mostrar cosas en pantalla. Para demostrar la capacidad de Viola, Pei Wei escribió un navegador web, que permitía mostrar HTML con gráficos. Comenzó a distribuirlo en mayo de 1992. El único inconveniente que tenía el Viola era la complejidad, para el usuario, de instalarlo en su ordenador.

En el entorno comercial, uno de los que se unió al desarrollo fue Dave Raggett de HP Labs Bristol (Inglaterra), creando el Arena WWW Browser.

Y por su lado la Universidad de Kansas escribió un navegador de hipertexto llamado Lynx. Que funcionaba en modo texto. Se diseñó para buscar información interna en el campus, pero el estudiante Lou Montulli, lo adaptó al World Wide Web y lanzó el Lynx 2.0 en marzo de 1993.

Marc Andreessen y Eric Bina desarrollaron el conocido navegador Mosaic en febrero de 1993, que estuvo disponible en el proyecto web para XWindows. Marc tenía muy en cuenta los comentarios de los usuarios y los iba incorporando al navegador.

Thomas R. Bruce, Universidad de Cornell, creó el primer navegador para PC, llamado Cello. Navegador desarrollado para Windows, distribuido desde marzo de 1993.

Marc Andreessen, junto con el hombre de negocios Jim Clark, fundó Mosaic Communication Corp., que en abril de 1994 cambia su nombre por Netscape Communication Corp. Contrataron a Lou Montulli (Lynx), ficharon al equipo principal que desarrolló Mosaic y se dispusieron a desarrollar su navegador Netscape Navigator. Aplicando una estrategia de marketing sin precedentes, regalaban el producto con el fin de que se extendiera masivamente.

Microsoft les seguiría la pista creando el MS-Explorer a finales de 1995, e iniciando una larga batalla comercial para arrebatarles el mercado.

Tim Berners-Lee:

"En octubre de 1994 me trasladé a MIT para fundar el Consorcio WWW (en colaboración con el CERN y con el soporte de DARPA y de la Comisión Europea).

En abril de 1995 abrimos la primera delegación del W3C en Europa situada en el INRIA al que pronto siguió la de Japón (situada en la Universidad de Keio). Forman el Consorcio ingenieros de todo el mundo, que bajo los principios de Neutralidad, Coordinación y Consenso, tienen el objetivo de mantener y desarrollar el proyecto web para el bien común, manteniendo sus desarrollos abiertos fuera de los intereses comerciales que desean convertirlos en estándares propietarios."

Tim Berners-Lee nunca se ha beneficiado personalmente del WWW, ha

dicho en repetidas ocasiones “NO” a oportunidades que se le presentaban,

si éstas amenazaban la independencia o la integridad del proyecto web. Las

repetidas negativas que encontró en sus peticiones de ayuda para seguir

desarrollando el proyecto web, hicieron que Europa volviera a perder una gran

oportunidad, dejando escapar a Tim Berners-Lee a EE UU, donde se constituyó el Consorcio que coordina el desarrollo del World Wide Web.

Las redes de área local se iban instalando por los distintos campus americanos, organizaciones y empresas. La función de ARPAnet de servir como “red troncal” de transporte fue progresivamente asumida por NSFnet.

La función inicial de conectar los centros de supercomputación entre ellos, pronto se vio desbordada por muchos otros usuarios que empezaron a utilizar la red, por lo que las líneas de 56 kbps se colapsaron y fueron pronto sustituidas por enlaces de 1,5 mbps.

En 1990 después de veinte años de experimentación, ARPAnet fue puesta fuera de servicio. De los cuatro ordenadores y decenas de usuarios, en 1969, que componían la red de ARPAnet, se pasó a un crecimiento exponencial, estimando en 912 millones de host (ordenadores) los que formaban parte de Internet a finales de 2011 y 2100 millones de usuarios.

En 1991, se hizo una segunda gran ampliación de NSFnet hacia líneas de 45 mbps, que supuso un reto tecnológico tanto para los ingenieros que lo diseñaron como para los proveedores de equipos, que sabían que esas velocidades aún no eran factibles comercialmente.

La fundación NSF administraba en 1992 la red troncal de Internet, y fue esta fundación con

Steve Wolff a la cabeza, quien decide privatizar y permitir el tráfico comercial dentro de la red. En 1993 se otorga esta función a la pequeña empresa Network Solutions Inc., que creció como la espuma tras el aporte inicial de 4 millones de dólares por parte de la NSF. En 1994 el grupo SAIC compra Network Solutions Inc., se renegocia el contrato de manera que podían cobrar 50 dólares al año por cada nombre, y darían un 30% de estas cuotas a un fondo de infraestructura de la NSF. Fue el comienzo de la primera guerra de dominios.

Steve Wolff

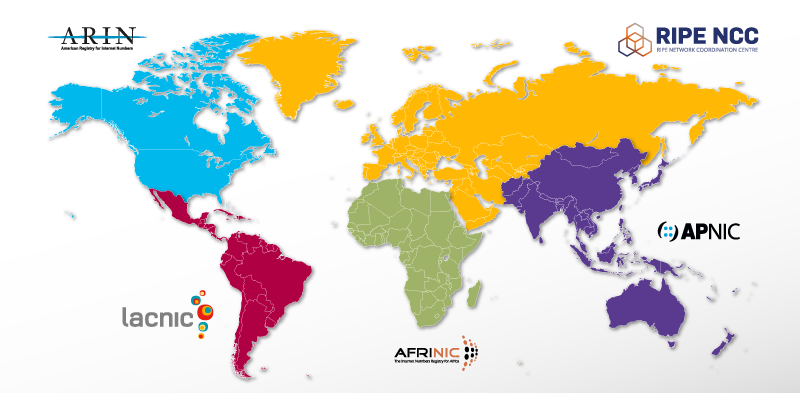

En 1992 se pone en marcha una estructura operativa

RIPE-NCC,

una organización neutral y totalmente independiente, sin control por

parte de gobiernos y empresas privadas.

En la actualidad existen cinco

grandes centros que se encargan de gestionar un bien tan escaso como son

las direcciones IP en cada uno de los continentes:

RIPE-NCC,

ARIN,

APNIC,

LACNIC,

AFRINIC.

El

incremento constante del tamaño de la red hizo cambiar la estructura de

los routers (o encaminadores). Inicialmente existía un único algoritmo

de enrutamiento; al crecer drásticamente el número de redes conectadas,

se dividió el trabajo de cada uno de ellos, implementando un sistema

jerárquico con dos tipos de protocolo (

IGP y

EGP) que trabajan en el interior de una cierta zona de Internet o en su exterior.

Y en el año 1995, se hacía realidad una de las condiciones impuestas a

NSFnet por

Steve Wolff: “

La red debe autosostenerse con los ingresos que cada organización logre obtener localmente”. El subsidio de la NSF dejaba de tener sentido.

La red fue puesta fuera de servicio, siendo sustituida por enlaces y redes troncales operados por proveedores privados que gestionarían el acceso a Internet.

Steve Wolff es el responsable de que Internet sea como la conocemos hoy, tomando decisiones complejas en contra de todo el mundo académico, decidiendo privatizar paulatinamente la red y creando la estructura de NAP (Network Access Points) en donde los operadores comerciales estaban obligados a hacer peering (intercambio de tráfico) de forma gratuita entre ellos.

En 1996 Jon Postel, director de IANA, propuso la creación de

150 nuevos nombres de dominio genéricos. En noviembre, la

Internet Society propone crear un grupo de discusión sobre el rediseño de los

gTLD, el

Internet Ad Hoc Committee (IAHC), que redactaron un documento, Memorando de Entendimiento (MoU), para los Nombres de Dominio Genéricos de Nivel Superior (

4 de febrero de 1997).

El 1 de mayo de 1997 el IAHC se disuelve tras plantear en un nuevo documento,

Generic Top Level Domain Memorandum of Understanding, la creación de 7 nuevos

gTLD:

".firm" (negocios) ".shop" (ventas) ".web"(entidades relacionadas con la WWW) ".arts" (cultura y entretenimiento) ".rec" (recreo y ocio) ".info" (servicios de información) ".nom" (particulares).

También se contemplaba la liberalización del negocio de los registros, monopolizado hasta ese momento por

Network Solutions Inc. (NSI). Esto implicaba la creación de un consorcio internacional,

CORE, que se encargaría de las funciones de gestión de los dominios a través de 89 nuevos registradores de todo el mundo.

El 75% de los registradores que habían superado las pruebas de solvencia económica y técnica estaban fuera de los EE UU, concretamente en Europa. Esto provocó que, el 30 de enero de 1998, el gobierno de EE UU intentara impedir el inicio de las operaciones del

gTLD-MoU mediante el llamado "

Green Paper", con el que

Ira Magaziner anulaba la autoridad y el proceso de constitución del

CORE, Al desaparecer la posibilidad de que los nuevos dominios entrasen en circulación, fracasaron muchas de las empresas registradoras que habían puesto 10000 dólares a fondo perdido.

En el

Green Paper se invitaba a la comunidad internauta a opinar sobre la creación de un ente internacional de gobierno de Internet que supliera al IANA en la coordinación de los gTLD y las direcciones IP. Todo ello provocó una auténtica revolución en contra del

Green Paper. Pero, la realidad fue que

el gobierno de los EE UU había conseguido paralizar el proceso, obstaculizando un sistema que le hubiera hecho perder poder en el control de los dominios de Internet.

El 5 de junio de 1998, el Departamento de Comercio del Gobierno de EE UU emitió el

White Paper , retractándose de algunos de los puntos del

Green Paper. Se buscaba crear una nueva organización que reemplazara al

IANA (organización privada sin ánimo de lucro).

Surgieron diversas organizaciones que aceleraron la creación de ICANN. Desde su creación ICANN se ha ocupado de la introducción de la competencia en la administración del registro de nombres de dominio. El administrador del registro seguiría siendo NSI, único registrador de los dominios genéricos .com, .org, .net.

NSI vio amenazado su monopolio y trató de impedir la constitución de ICANN, poniendo en peligro la estabilidad de Internet.

El 10 de noviembre de 1998, ICANN, NSI y el Departamento de Comercio americano llegan a acuerdos: la prórroga del contrato al NSI como registrador autorizado durante cuatro años y el reconocimiento de ICANN como autoridad reguladora de las normas de registro de los nombres de dominio.

En noviembre de 2000 se decide añadir 7 nuevos dominios de primer nivel genérico (gTLD): .aero, .coop, .museum, .biz, .info, .name, .pro.

En 2003 se añaden: .asia, .cat, .jobs, .mobi, .tel, .travel.

A partir de 2014 el mercado se flexibilizará y gradualmente se pondrán en marcha cientos de dominios de primer nivel.

La IANA permaneció hasta octubre de 2016 bajo supervisión del gobierno de EE.UU. Hoy este control gubernamental ya no existe y la gestión de las funciones de la IANA recae solo en manos de la ICANN.

INTERNET en ESPAÑA

________________________

En 1972 la

Universidad Autónoma de Barcelona (UAB) conectaba su Centro de Proceso de Datos con el ordenador central del Ministerio de Educación y Ciencia,

UNIVAC, al que se conectaban varias universidades de toda la geografía española.

En 1982 la UAB implanta el primer

VAX de alta potencia, 512 K de memoria, tres unidades de disco de 67 Mbytes, lectora de tarjetas perforadas y 6 pantallas VT-100 (sin teclado). La UAB opta por la desconexión del sistema centralizado, debido al alto coste de la línea telefónica.

En España las primeras conexiones permanentes fueron académicas y se establecieron en la

Universidad de Barcelona (UB) con la red EARN, en 1984. Esta universidad lideraba en España el proceso de interconexión con otras universidades. La red permitía a las universidades disponer de correo electrónico y acceder al teleproceso. Además a través de

gateways (pasarelas) se podía acceder a otras redes (ARPAnet, CSnet, USEnet, JAnet....)

A principios de 1985 la red EARN-UB empieza a usarse de manera progresiva. A partir de febrero se establece el enlace desde el Centro de Cálculo de Montpellier (punto de partida de la línea intercontinental hacia la Universidad de Cornell, EE UU) hasta la Universidad de Barcelona (UB), por lo que se convierte en un nodo internacional que da servicio al resto de nodos franceses.

La Universidad Autónoma de Barcelona se conectará en junio a la Universidad de Barcelona. Pero debido a que utilizaban un ordenador VAX (no IBM) la conexión era tediosa, debiendo utilizar unidades remotas IBM de la Universidad de Barcelona. En 1988, finalmente, conectaron el VAX a la red.

Los primeros contactos con los servicios de Internet (news, correo electrónico,...) los tuvo el

Instituto de Física Corpuscular, en 1985, a través de la red FAEnet (Física de Altas Energías Network). Red formada por grupos de Física de las universidades de Valencia, Cantabria, Zaragoza, Madrid, Barcelona, y el

CIEMAT. Utilizaban protocolos

DECnet, debido al uso de ordenadores

DEC, que mediante pasarelas permitían el acceso a algunos servicios de Internet. En 1990 se conectaron a la red EARN.

A mediados de los años 80 se remontan también los orígenes de la conectividad comercial por parte de pequeñas empresas, incluso particulares desde sus hogares. Esta conexión se realizaba mediante servidores

BBS (Bulletin Board Systems). Aunque hoy nos parezca extraño, este modelo perduró durante más de una década. El voluntariado, el ansia de difundir nuevas técnicas de comunicación y el afán de establecer contactos y relaciones profesionales movían a una serie de personas a montar estos servidores en sus domicilios particulares. Normalmente, solo estaban activos durante la noche, ya que debían compartir la línea telefónica particular.

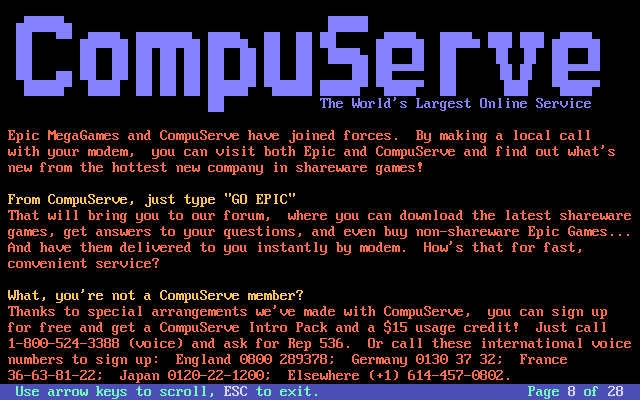

En el ámbito internacional la BBS que más creció fue

CompuServe que llegó a tener millones de usuarios en todo el mundo, su oficina central más cercana estaba en Grenoble.

Compuserve vendió muchas cuentas de correo electrónico en España, además de dar el acceso a sus contenidos centralizados en América. Recogían las llamadas en los nodos de Madrid y Barcelona, y las redirigían a su central. Muchos pioneros españoles empezaron con una cuenta en Compuserve, que les cobraba la suscripción, el tiempo que estaban conectados y la llamada telefónica.

Compuserve en 1996 comienzan a ofrecer servicio de Internet. Finalmente fue comprado por

American Online (AOL), y cerró el 1 de julio de 2009.

El 2 de julio de 1990 inicia su andadura el Centro de Cálculo de la Universidad Autónoma de Barcelona (con

LLorenç Guilera) y el Centro de Proceso de Datos (con

Florenci Bach).

En 1991 se funda la compañía

Goya Servicios Telemáticos S.A., el primer proveedor privado de acceso a Internet en España. Goya fue pionera, hasta 1994 no aparecerían otros proveedores.

La primera conexión real a Internet (es decir, con protocolos TCP/IP) se realizó en 1991 en el servicio de informática de la Universidad de Valencia.

El primer servidor web experimental se instaló en Santander, en la Universidad de Cantabria, en 1992. El artífice fue el doctor en Física de altas energías,

Ángel Camacho, relacionado por motivos académicos con el CERN, quien con poco éxito ofreció a sus colegas en congresos y reuniones, los programas que directamente se traía de Suiza.

Exceptuando los primeros escarceos con el correo electrónico, que tuvieron las BBS más avanzadas a finales de los años ochenta, y de las pioneras conexiones a las redes EARN y DECnet de algunas universidades, podemos asegurar que Internet aterrizó en España a principios de la década de los noventa.

La puerta por donde entró fue la de la red académica:

RedIRIS.

En 1988

Juan Riera, del DIT, junto a

Francisco Ros, de Fundesco, y con el apoyo de Ramón López de Arenosa, consiguieron que dentro del

Plan Nacional de I+D se aprobara un proyecto para desarrollar una red de datos que supuso la creación y puesta en marcha del Programa IRIS, que en el inicio gestionó

Fundesco. Posteriormente, el 1 de enero de 1994 se traspasó al Centro de Comunicaciones del

CSIC y, en 2004, el

MCYT transfirió la gestión de RedIRIS a la Entidad Pública Empresarial

Red.es.

Durante la primera mitad de 1990 se desplegó un servicio experimental de conexión a Internet y en el mes de julio de 1990, ya había cuatro centros con interconexión plena:

• Fundesco.

• DIT-UPM <www.dit.upm.es>.

• CIEMAT (Madrid), <www.ciemat.es>.

• Centro Informático Científico de Andalucía, <www.cica.es>.

A partir de marzo de 1991, comenzó la fase de despliegue del servicio de

RedIRIS, englobado en lo que llamaban Servicio de Interconexión de Redes de Área Local (SIDERAL). Sus inicios fueron mediante una conexión a NSFnet.

La introducción del ordenador personal (PC) hizo que las facultades fueran descentralizando su informática progresivamente y empezaron a surgir las redes de área local (LAN), que unían, con muy diversas tecnologías, los diferentes recursos informáticos distribuidos por los departamentos.

Para solucionar el problema que representaba la conexión de las distintas redes locales universitarias,

RedIRIS inicialmente optó por el estándar de

protocolos OSI.

.

Las redes de área local (LAN) utilizaban ya los protocolos de Internet, TCP/IP. Sin embargo, las redes de área extendida (WAN) requerían un operador de telecomunicaciones y dependían del gobierno, por lo que solían usar protocolos OSI. Eso hacía que conectar una red local de una oficina con otra remota fuera extremadamente difícil y costoso.

Finalmente, la RedIRIS tomó la decisión de utilizar en todas sus interconexiones los protocolos TCP/IP abandonando progresivamente el modelo OSI.

A principios de 1992 estaban funcionando unas treinta instituciones, con más de 1000 máquinas conectadas. En abril RedIRIS participó en la creación del Centro Europeo de Coordinación de direcciones

RIPE.

En julio de 1992 se descentraliza el NIC (Network Information Center) y RedIRIS asume las funciones de delegado para España. Desde ese momento RedIRIS asume el registro de nombres de dominio para las organizaciones españolas.

En mayo de 1994 hay en España cien organizaciones conectadas, con 20000 máquinas.

El 1 de enero de 1994 las funciones de registro de dominio ".es " pasaron a depender del CSIC (RedIRIS), hasta que es traspasado al Ministerio de Fomento.

En 2005, miles de empresas y decenas de miles de particulares de Cataluña que se

adhirieron a la Asociación Puncat, lograron de la ICANN, que

se reconociera ".cat" como un dominio de interés lingüístico y cultural

de primer nivel. En poco más de cinco años, .cat logra tener unos 50000 dominios activos.

RedIRIS siguió una política muy restrictiva a la hora de ofrecer conectividad a centros que no fueran estrictamente académicos.

Por su parte

Goya Servicios Telemáticos S.A., centraba su comercialización en Madrid.

El hecho de que solo hubiera dos proveedores de acceso a Internet, RedIRIS y

Goya Servicios Telemáticos S.A., llevó a pintorescas situaciones. El primer periódico que publica sus contenidos en Internet,

Avui, lo hace utilizando recursos de la universidad (RedIRIS) en 1995.

Dada la creciente demanda empresarial, a mediados de 1994 comenzaron a surgir

iniciativas privadas para comercializar el acceso a la red. Por orden de creación: Servicom, Cinet, Asertel, Abaforum, Intercom, Redes TB,...

Al principio cada proveedor instalaba grupos de módems en las ciudades más importantes y, a través de una línea permanente llevaba las llamadas de sus clientes a su central, y de allí a Internet. En esta primera etapa de Internet

los operadores telefónicos de todo el mundo no tenían ni el más mínimo interés por esta nueva tecnología de la comunicación.

Una vez que los pequeños proveedores hicieron el duro trabajo comercial de la educación de la demanda en un sector totalmente nuevo y emergente, los grandes operadores de telecomunicaciones se fueron posicionando y arrebatando cuotas de mercado a las pequeñas empresas

ISP, que finalmente desaparecerían o serían absorvidas por las grandes empresas de telecomunicaciones.

Fuente de información:

Cómo creamos Internet (

Andreu Veá)

Mil millones de metros de cable submarino son los responsables de que tengamos Internet en nuestras casas

___________________________________________________

Más información:

https://historyofcomputercommunications.info

Nuevo récord de velocidad en transmisión de datos por Internet (2020): 178 terabits por segundo (178.000.000.000 kbps)

Japón rompe el récord de velocidad en internet (2021): Lograron transferir datos a 319Tbps (379.000.000.000 kbps)